ORIGINALLY PUBLISHED IN ENGLISH: Bringing the Security Analyst into the Loop: From Human-Computer Interaction to Human-Computer Collaboration

作者:Liz Rogers, IBM(资讯)安全

摘要

本案例讲述了IBM人工智能(AI)安全软件团队基于民族志和用户研究,放弃一个被购买决策者视为“酷”、“令人印象深刻”、和“复杂“的产品核心功能,采用新的交互式知识图谱(KG)的可视化设计,从而使得安全分析师用户们可以更加简单地理解和使用知识图谱(KG)。在民族志和用户研究的成果的指导下,QRadar Advisor with Watson团队创建了新的可视化知识图谱(KG)。与联想式的人工智能(AI)和“互联网的方式“相比较而言,这个新的可视化知识图谱(KG)更加匹配安全分析人员调查潜在安全威胁的实际方式。该新功能由IBM在2020年第一季度发布,并已被用作IBM开源设计系统的组成部分。此外,IBM目前正在对它作为专利申请的提交内容进行审查。 IBM及其团队的承诺用一个更贴近用户的心理模型和用户实践的组件来代替基本的人工智能AI组件的做法,代表了用户和以用户为中心的设计的胜利。设计人员和软件工程师与安全分析人员和领导者共同创建了一个知识图谱(KG)的表示形式,该表示形式的重要性不仅仅在于其“引人注目“的作用。因此,本案例研究充分说明了民族志研究可以加强产品团队开发AI应用程序的信心。以AI为主导、强调AI可以作为自主“黑匣子”系统的说法是应该被反对的。与此同时,与用户心理模型相一致的相关替代方案已经被提出和采用。产品团队可以创造识别AI软件和用户之间的相互依赖关系的新的体验,从而为打造AI软件和人类之间的更多的合作方式铺平道路。

介绍

在2018年春季,在这个项目成立后约18个月,IBM Security 设计师开始与Watson一起研究一款人工智能(AI)驱动的安全软件应用程序——QRadar Advisor——并希望它可以改善产品的用户体验并提高采用率和使用率。 毫不奇怪,设计团队有很多关于产品团队的更广泛的问题。 顾问做什么? 这款程序是如何运作的? 更重要的是,其目标用户(企业安全分析师)如何使用这款应用程序,他们是否发现所展现的信息有意义且有用?QRadar Advisor设计团队认为这些问题的答案虽然无法从典型的客户电话访谈中获知,但确定了对安全工作者-分析师和领导-在他们工作环境(安全运营中心,缩写为SOC)进行民族志研究的需要。见图1。

图1:安全运营中心 – 资源: http://media.marketwire.com/attachments/201702/72527_bulletproof-SOC-large-tiny.jpg

SOC通常是由经验丰富的安全分析师,工程师,响应者和负责监督安全操作的经理团队组成的。 他们倾向在黑暗的的工作区和安全团队成员协作,至少被两个屏幕(如果不是三个屏幕的话)包围。 SOC团队负责保护公司资产免受安全威胁,他们通过监视,检测,调查和响应来发现潜在的安全漏洞。 安全运营团队使用一系列技术,软件来帮助他们收集、监视和分析数据,以寻找可能的网络安全遭到入侵的可疑证据。带有Watson的QRadar Advisor就是这样的一款软件。QRadar Advisor旨在帮助分析师针对其网络最重要的威胁,更快地调查和找出未被其他工具识别出来的漏洞。

开发企业安全软件需要对信息知识技术,软件开发流程和网络安全行业深入的了解。 当产品团队需要了解其用户的实践,经验以及目标时,他们还需要了解该软件背后的技术。对于没有计算机科学背景的设计师和设计调研师来说,这尤其是一个挑战。因此,对于IBM而言设计师和设计调研师常常在项目开始时花费大量时间去了解他们开发/(研究和设计)的软件如何能够帮助用户完成任务/目标。

对于要求软件开发员和产品经理从用户的角度考虑相比,把设计师和设计调研师介绍给开发团队被证明是一样具有挑战,同时也充满着痛点和改善的机遇。

众所周知,带有Watson的QRadar Advisor是一个复杂的应用程序:难以正确配置和使用,并且提供给分析师的见解尤其不清晰。 由注重后端功能为目的,忽略了顺畅用户体验的软件工程师们设计和开发的QRadar Advisor,因为不能够被分析师们顺利地理解如何使用产品的核心功能,而受到了分析师们的抵制。此外,这款应用程序不能够与它所嵌入的软件系统进行很好地整合。尽管不是很快或者很容易,但是分析师可以完成许多与QRadar Advisor提供的相同的任务。

考虑到产品的复杂性以及分析人员是否使用该应用程序的准确性,该团队的首席设计研究员游说提出可以直接接触分析师和他们同事工作环境。 她认为只有在SOC环境下通过与正在工作的安全分析师和领导进行观察与交谈,才可以充分理解这些人的工作方式,为什么他们比其他人更喜欢特定的工具和资源,以及他们在使用或者购买他们工具时的目的。

本文首先介绍了应用程序QRadar Advisor的更多技术说明,然后提供了一些有关网络安全领域的知识背景,和与之相关的AI的希望与担忧,以及它所存在的环境。 接着,本文总结了该项目的具体研究目标和方法,主要发现以及研究成果。 最后,本文对项目做出了总结。

QRADAR ADVISOR WITH WATSON

QRadar Advisor with Watson 是一个被安全分析师和事件响应者使用的,用来增强QRadar的容量/能力的,基于云端的应用程序。QRadar是一款行业领先的信息安全和事件管理工具(SIEM)。公司采用SIEM解决方案来监控其环境中的实时威胁,并捕获异常行为和可能的网络攻击。像其他SIEM一样,QRadar的工作原理是收集和标准化来自网络基础结构,安全设备和应用程序的日志和流数据,并将这些数据与预定义的规则集进行比较。如果一个规则中的几个条件被满足(即有数个相关“事件”在网络设备上相继发生),那么则QRadar会生成“攻击”, 用于警告安全操作可能发生了安全漏洞。这些警报通常是可能未经授权访问和使用企业资产的第一个线索。不幸的是,由SIEM触发的许多警报都是虚假警报,而安全分析人员花费大量时间试图确定警报是真是假。

QRadar Advisor with Watson 旨在帮助安全分析人员在收到这些QRadar警报后迅速做出下一步决定。营销材料QRadar Advisor的地位尤为突出,因为它是一款由AI支持的应用程序。 参见图2。

图 2: IBM’s QRadar Advisor with Watson. Source: https://www.ibm.com/us-en/marketplace/cognitive-security-analytics

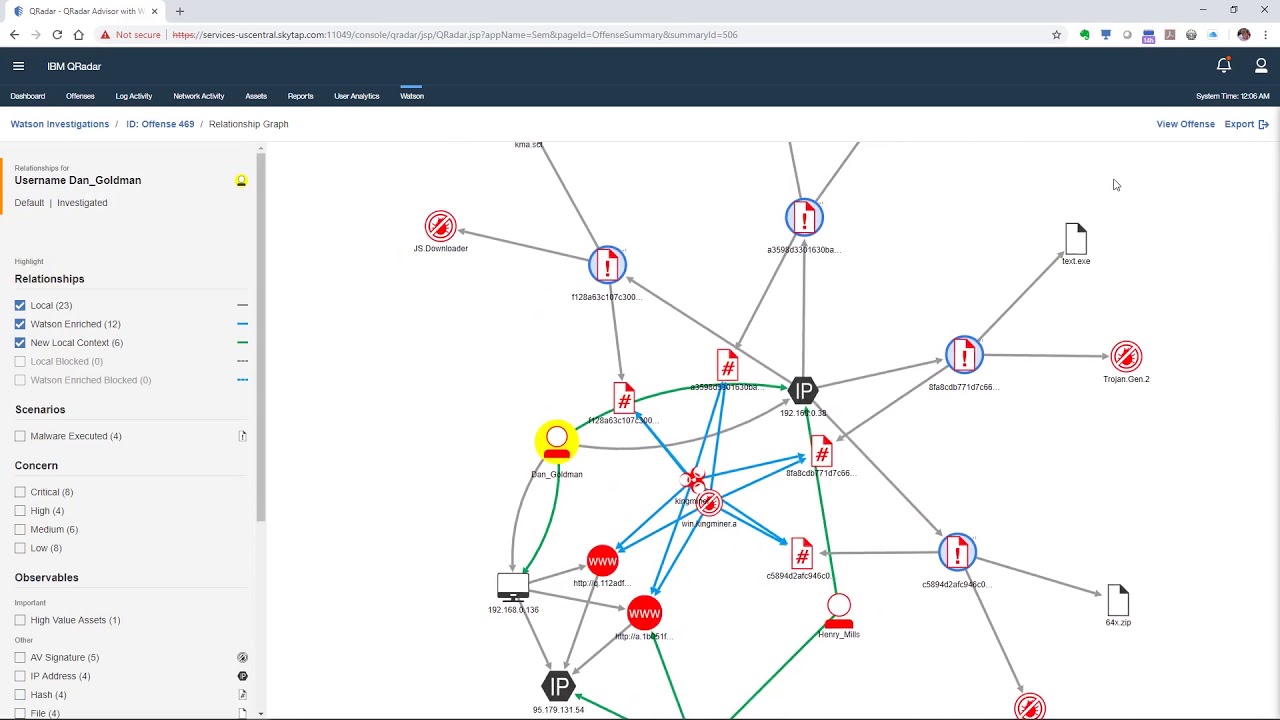

QRadar Advisor顾问程序从网络日志以及防火墙和防病毒设备等安全设备收集内部数据,并将此数据与从网络上挖掘的外部威胁情报相比对。QRadar Advisor使用自然语言处理(NLP)模型来提取和注释存储在知识图谱(KG)中的外部数据。这是这个应用程序中“AI”或“ Watson”的部分。知识图谱(KG)是功能强大的工具,可用于显示与安全事件相关的所有实体(节点)(例如,内部主机,服务器,用户,外部主机,网站,恶意文件,恶意软件,威胁参与者,等)以及这些实体之间的关系(边)。图3描述了QRadar Advisor对安全事件的调查。调查结果是一个最初被QRadar做出攻击的所有实体的综合视图,以及被QRadar Advisor基于NLP模型挖掘出来的在网络中有潜在威胁的其他实体。

图3:具有Watson调查的QRadar Advisor。 资源 https://www.youtube.com/watch?v=a5xaY6THvKo

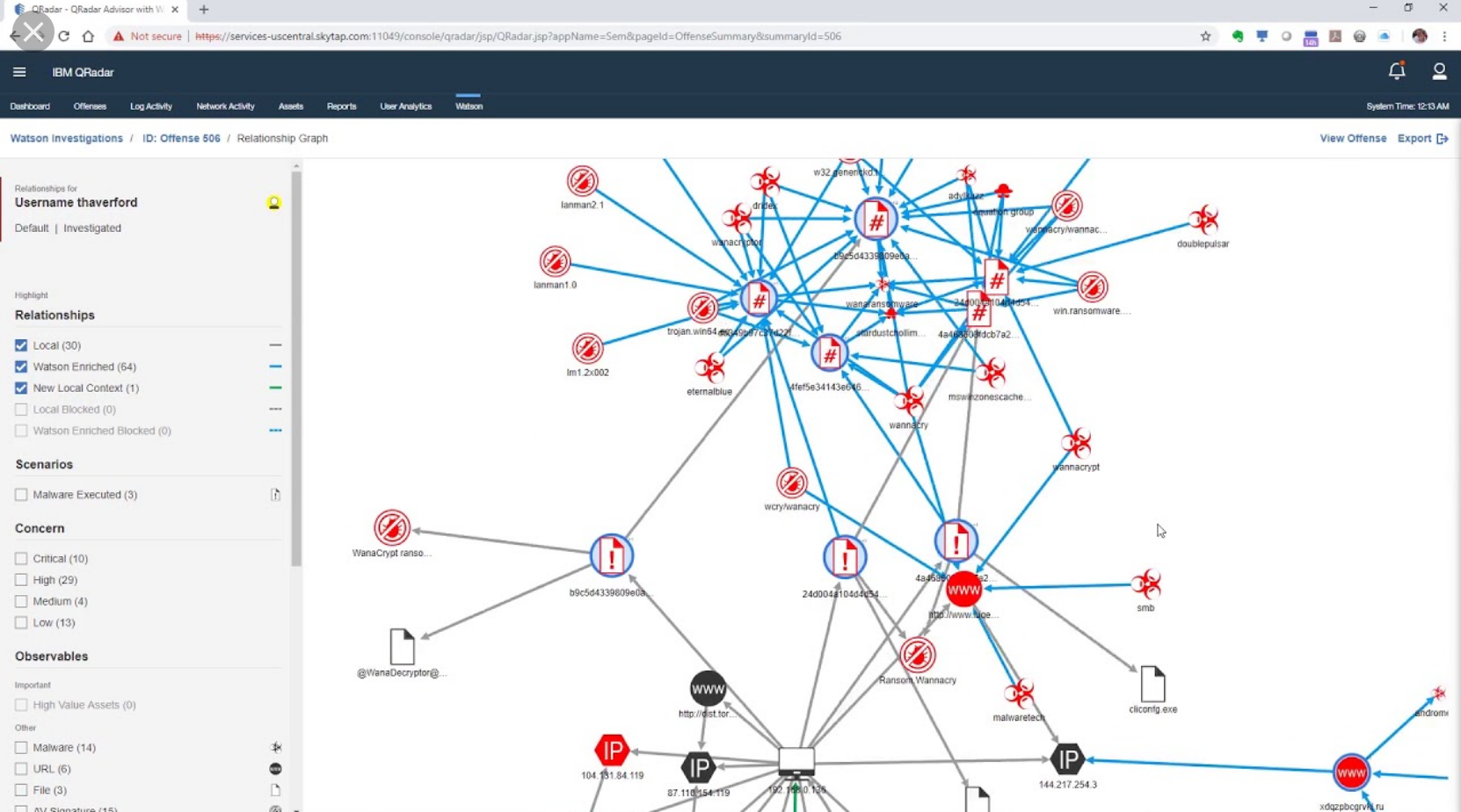

但是,知识图谱(KG)可能变得相当复杂,特别是因为安全事件可能涉及数百个节点和边缘。有关对复杂安全事件进行QRadar Advisor调查的示例,请参见图4。

图4:带有Watson QRadar Advisor Investigation的QRadar。 资源 https://www.youtube.com/watch?v=NaGpfttxA2s

背景

网络安全与人工智能技术

凯捷(Capgemini)在2019年的最新调查中,对来自10个国家、7个行业的850位高管进行了问卷调查,其中69%的人回答说,他们只有在人工智能(AI)的帮助下才能应对网络攻击。他们为什么不这样认为呢?对于网络安全来说,AI被认为是“网络安全的未来”(2019年《福布斯》)。根据至少一家生产人工智能为基础的安全软件的公司的说法,AI正在将“安全性”从“常规的过时策略”解放为一种作为“科学”带来“革命性变革”的安全(Cylance 2018)。当然,关于AI对安全行业影响的公开辩论也有另外一方面。客户对于前景过于乐观的人工智能(AI)和机器学习(ML)的解决方案的功能表示失望。此外,网络安全专家预测公司在使用人工智能技术开发软件的时候可能会经历一些新的不良因素,这些因素是由AI系统的开发所带来的与AI系统有关的企业漏洞。针对这一现象的预测,网络安全专家对“滥用人工智能技术”(的做法)提出警告 (Future of Humanity Institute 2018)。

尽管安全专家可能会认为AI带来了安全性,但安全社区之外的AI专家似乎对AI可能产生的影响并不乐观。例如,皮尤研究中心根据2018年对979名AI专家的调查得出以下结论:“网络化AI将增强人类的有效性,但同时也威胁着人类的自主权,代理权和能力”(Pew Research 2018:2)。尽管一些AI专家确实认识到AI可能带来的好处。例如,科学和人道主义工作的进步),但总体而言,被Pew所调查的专家们似乎更加相信,负面影响将超过正面影响。对于这些怀疑论者而言,采用AI技术将导致人们失去对自己的生活,工作,对自己的思考能力以及独立行动能力的控制(Pew Research 2018)。根据这项研究,人工智能技术不仅可能导致对作为人类意味着什么的重新思考,而且还可能导致“传统社会政治结构的进一步侵蚀”,“更大的经济平等”,数字化“有”和“没有”之间的鸿沟,以及权力和财富在少数几个大型垄断企业手中的集中。

计算的普遍社会意义

自从人工智能出现和普及之前,人们就一直在担心新技术的破坏性影响。 尤其是,一直作为科技力量、吸引了无数拥护和批评的计算,把社会和人与人之间的关系转型成了自然与物质之间的关系。自推出以来,计算机已迅速被当成一个常规文书工作可以被机械化和自动化的证据,也肯定了人类可以摆脱重复的体力劳动,和技术可以是保持持续增长和繁荣的资源(Prescott 2019)。

像以前的技术创新——如蒸汽铁路,汽车,无线电和电力(Pfaffenberger 1988; Moss and Schuutz 2018)一样,计算的愿景与启蒙思想的进展和具有可变性社会潜能的的技术有很大关系。技术创新代表着人类的进步和对自然的掌握,这一概念成为了“现代文化的大师叙事”的基础(Pfaffenberger 1992)。在这个主要的叙述中,人类历史是一个随着时间从简单工具到复杂机器单线性发展的过程。 因此,计算机是人类不断增强的技术力量,对自然界的控制以及对科学的应用的证据。简而言之,它们是对社会化过程在机械化社会中的的比喻的来源(Ortner 1973)。

当然,不是所有人都接受这个主要的叙述观点,并且有人以抵抗机械化和以各种形式去挑战这些主导观点来寻求和重申人类的自治和控制权。 对于一些人而言,抵制是以引入新技术的形式出现的,这些新技术颠覆或颠倒了现有技术的普遍含义。 因此,个人家用计算机的发明可以被看作是通过颠覆了计算机与大型企业相关的这一普遍认识和形象来重申人类自治和控制的策略(Pfaffenberger 1988)。

其他人则通过颠倒新技术(例如AI)的主旨和主要意义来削弱或破坏这个主叙述。一些研究人员,比如Moss和Schuur(2018)以及boyd和Crawford(2014)指出了AI技术和大数据的意义和神话是如何促进了对技术的客观性,准确性和真实性的理解,以及对人类的容易出错,效率低下,并且适合被机器主导控制的情况的理解。 其他研究人员则专注于让人们意识到机器学习、AI模型和算法对人类的有多么依赖(参见Klinger和Svensson 2018; Seaver 2018)。正如Seaver(2018)所说:“实际上,没有算法是不受人类监管的。 如果你在一个循环中没有看到人类的参与,那么你只需要寻找更大的一点的循环。” 还有一些人注意到主叙述中不准确的地方并提出:人工智能并不是客观的, 因为机器学习的模型和算法存在偏差。

在把AI理所应当地当成神话的大环境下,这些研究人员可以被看作是反(AI的)叙述的作者。然而,这些反(AI的)叙述的作用并不仅仅是质疑了主叙述的观点。他们还质疑了它(AI)的根本原则之一, 即技术是根据自身内部逻辑发展的一种外部的自主力量。通过这样做,这些反叙述者使人们更好地理解了科技和材料是如何在社会中获得代理,并作为代理机构运作的。

从人与机器的对抗到人与机器的合作

随着AI技术变得越来越复杂,很难想象AI不被当成是陈列展示的代理机构甚至是自治的人造产物。但是,即使在AI技术普及之前,代理机构(尤其是非人或物质代理机构的概念)已经成为各种学科的讨论和探究的丰富来源。有两种(讨论)方法——一种以技术为中心的方法,另一种以人为中心的方法——两者都遭到了全面的批评:第一种(以机器为中心的方法)被批评的点在于,它是笃定地假设技术“在很大程度上是外生的,同质的,可预测的,稳定的,并且能够在时间和地点的纬度方面按照构想和预设进展和运行”;第二种(以人为中心的方法)被批评的点在于,它最小化了技术本身的角色并把重点放在了人类在(人机)关系方面(的作用)(Orlikowski,2007)。

与这些方法相反,已经提出了人类物质关系的“后人文主义”概念化,试图避免早期概念的决定性,并挑战了将代理权限制于人类的传统方法。 这些备选概念引起了人们的注意,在实践中人类和技术密不可分,相互构成。而且,它们挑战了其他方法提出的代理概念。 代理不再以人类固有的基本素质来定义,即“行动的能力”,而是定义为在“纠缠的社会/材料网络”中的“行动的能力”(Orlikowski,2007)。代理是发生的事情,而不是被拥有的物质。 因此,人类和机器都可以被理解为是证明在某种意义上可以执行具有结果的行动的代理,但是两种代理是交织在一起的,而不是相互独立的(Rose and Jones,2005)。

Neff 和 Nagy(2018)认为“共生代理”是一种更恰当的表达方式,因为它可以捕捉人机通信中人与技术代理的动态本质,其中用户同时影响技术并受到技术的影响。调研更偏向一种人机关系的概念化,这种概念认为人类的例常和科技是灵活可变的,尤其是互相之间的关系:当面临新的科技工具和功能时,人们会改变他们的现有例程,正如在人类使用当前工具和科技却无法达成目标的时候,科技工具和功能会被抵制和修改一样(例如物质代理会被改变)(Leonardi 2011)。那么,人们如何工作并不取决与他们使用的技术,甚至不用管这些技术可能有多么的有限制。相反,人们在与技术工具的互动中能够(在现有条件和材料范围内)“选择其他方式”(Orlikowski,2000)。

研究目标和方法

在IBM,设计研究人员需要有所取舍、适应产品的快节奏。接触IBM的产品用户常常是很具有挑战性的,并且研究人员通常没有预算来支付非客户用户的招募、访谈转录以及给他们的专门报偿。此外,IBM网络安全类的产品本身的工作更加剧了复杂性。 IBM的许多安全客户端都具有成熟的安全操作,有专门的扩展团队保护其系统。客户可能会非常不愿意共享包含他们真实网络数据或信息的屏幕,因为这些屏幕信息可能会显示他们是如何设置他们的安全工具,从而使得他们担心有暴露其网络漏洞并损害安全的可能。与实地访问客户安全运营中心甚至进行视频通话相比,更常见的是由客户安全运营成员(可能包括或不包括实际使用该产品的人员)和感兴趣的IBM各方(例如技术人员、销售人员、提供负责业务的经理、工程师和设计师)一起参加电话会议。

但是,从此类电话中收集到的信息是有限的。QRadar Advisor“用户”的初始呼叫虽然内容丰富,但却无法使团队全面地了解安全分析师使用的流程和工具、他们的目标,以及他们在使用这些工具时会遇到的困难,还有在尝试实现这些目标时会遇到的限制。 设计团队认为,民族志将能够帮助他们了解安全分析师如何与市场团队的材料中所引用的“数据超载”和“噪音”进行交互并从中理出思路的。

因此,在2018年夏末,IBM设计研究人员被允许对使用QRadar Advisor的的安全分析师和安全领导在工作岗位上进行观察。这项研究于2018年5月和6月进行,包括对两个IBM客户的安全运营中心(SOC)的探访:一个是大型托管安全服务提供商,该提供商使用IBM安全解决方案为500多个客户提供安全服务; 第二个是大型零部件制造商,其安全团队由10名全球分布的人员组成。

研究人员在第一个安全运营中心探访了三天,在另一个则探访了一天。在探访这两个中心时,研究人员观察了六位不同的安全分析师,并会见了一位安全负责人及其下属。经许可,研究人员使用了录音机记录访问录音,然后转录。研究人员还拍摄了照片(这些照片因为包含客户数据,不能(在这里)分享)。 研究目标集中在以下三个目标上:

- 了解安全分析师当前如何监视威胁并分析、诊断、和分类安全事件以及驱动这些行为的原因;

- 了解安全分析师如何使用QRadar Advisor(或者不使用QRadar Advisor)来帮助他们实现他们的目标以及原因; 和

- 确定团队可以如何改进QRadar Advisor,以便安全分析人员可以更有效地完成他们的调查。

在民族志研究的发现和建议的基础上,研究团队组织了内部研讨会,最终确定了三个用户目标,以指导下一个QRadar Advisor主要版本的设计和开发。其中,下面这一用户目标推动了知识图谱(KG)的重新诠释:针对潜在的事故,L1安全分析师可以查看其网络中的实际情况,同时将分类效率提高五倍。

研讨会结束后,研究团队进行了额外的用户研究,以验证与每个确定的目标相关的用户需求,并评估了团队开发的不同设计概念是否能帮助用户实现既定的目标。与本案例研究最相关的是对通过respondent.io招募的五名安全分析师的访谈(这些访谈的重点在于收集用户对替补设计概念的反馈),以及与来自五个不同QRadar Advisor客户的另外八名安全负责人和分析师就最终设计概念进行的讨论。

主要发现

和其它工具的相互竞争

发现1:安全分析师不愿将新的工具并到他们已经熟悉的工作流程中,尤其是当他们已经建立起对现有工具的信任,并觉得这些工具使用起来比较有效率的时候。

安全分析师可以选用许多工具和资源(开源的、公共的、或商业化的)来监视网络流量中的可疑行为和活动。除QRada之外,研究团队还发现分析师使用了一系列网络安全设备(例如防病毒、防火墙、入侵检测和入侵防御系统)、威胁情报源,异常检测和用户行为分析、网络权限控制以及基于应用程序、网络、与主机和基础架构有关的日志收集。 信息过载对于安全分析人员来说是一个真正的问题,特别是因为许多工具和数据源没有很好地集成在一起,从而迫使分析人员必须手动挖掘和关联这些数据源。

因为安全分析人员必须核对和挖掘这些数据,他们形成了适合他们自己的最佳实践和策略——包括如何使用哪些流行的免费工具和处理数据。 这使得 QRadar Advisor常常要在分析师脑海中和这些现有的工具和资源竞争,然而,它并不总能赢。

“我不确定我是否有经常使用[QRadar Advisor这个应用],因为我还有很多其他日常可以使用的工具。” —安全分析师

加入“人”这个因素的考虑

发现2:安全分析人员依靠个人经验和对网络的了解来评估网络违规或“误报”。

分析人员调查的QRadar犯罪通常很复杂,并且他们所使用的工具也并不完善。在开始调查前,安全分析人员想知道他们应该先处理哪些案件。对于组织而言,这些违规的严重性并不完全相同,并且并非所有的违规都是真的安全事件。 严重违规和犯罪是对组织、声誉、和数字资产造成重大伤害的犯罪。它们通常涉及具有系统特权或数据访问特权的用户,而该特权是公司中其他人所没有的。 想象一下,如果一个网络钓鱼攻击成功入侵了公司首席财务官的笔记本电脑,那就会是一个严重的安全事件。

有时,一些网络违规/犯罪是“误报”,这意味着实际上并未发生违反行为。发生误报的原因有很多,其中包括:规则没有调整好所以无法将操作或事件识别为良性、应用程序无法访问由大型网络生成的所有内部安全数据,威胁智能分析还没细致到能够区分在IP地址托管的正常URL和恶意URL。 正如一位安全分析师告诉团队的那样:

“我曾经遇到这种情况:你们曾经将合法流量标记为恶意流量。然而,一旦我进入到URL级别,并且查看了你们的威胁智能分析,我意识到你们标记的其实是另一个站点。它托管在同一个IP上,但我却收到20项误报,就因为在印度有一篇关于名人的文章发布在很多网站,然后这些网站都托管在同一IP上。我们在印度有业务和工作人员,他们能够阅读这些新闻。当他们上网时,他们分享了这个报道…于是我收到了洪水般的警报。我当时甚至想着,“天呐,这是一个大规模的网络威胁事件,诸如此类的。” 事实证明,这不是智能分析出的错,而是智能分析被错用了。” ——安全分析师

安全分析师认为,没有任何一个解决方案(不管是否有AI的支持)可以像他们一样完全了解他们负责的网络。因此,毫不奇怪,安全分析师对那些主张自动化和AI全知的声明持有怀疑的态度。“我信,但也要再验证下”是我们团队从安全分析师那里一再听到的口头禅。安全分析师们认识到软件不是完善的,他们认为加入他们自身这一“人“的因素,可以填补安全工具的空白。

“有一些(自动触发的)编程规则可以引起很不良的后果。在几乎所有类型的编程中,你都无法穷尽应对所有的变量。这就是为什么(我觉得)工具必须仍然加入“人”的因素,因为这样做有利于本地和本地之间(的网络安全)。同时这也有利于远程到本地、本地到远程(的网络安全分析)。” ——安全分析师

权衡是优先考虑即时威胁还是潜在威胁

发现3:比起寻找潜在威胁,安全分析师更专注于保护组织的安全态势免受直接威胁。

在进行民族志研究时,研究人员发现,比起“可能发生的事情”,安全分析师更着重于识别安全事件期间“实际发生了的事情”。“可能发生”或“可能发生但没有发生”的事情对他们来说只是次要的。

“这就是[SIEM]分析师的全部要点。 你必须分析这些数据并指出正在发生什么。在挖掘信息时,你就是IT考古学家。” —安全分析师

“在我这边,归根结底我需要分析很多信息有,并试图在(安全威胁)事发后搜集造成该事件的原因。很多时候是紧急救火的情况。” —安全分析师

由于安全分析人员如此专注于最高优先等级的事件,大多数人并不认为他们有时间(或有义务)去主动搜寻网络中的潜在威胁。 优先考虑即时威胁而不是潜在威胁,这直接影响了安全分析师对待QRadar Advisor及其知识图谱(KG)的方式。 在我们的研究期间,分析师认为QRadar Advisor是“有时间(才去用的)……需要继续钻研”的“搜寻威胁的工具。

“这个(知识图谱(KG))为用户提供了……查看其他IP的机会,因为他们有时间也有资源可以查看并进行更深入的研究。对于我们来说,我们需要处理正在发生的事件。” —安全分析师

在安全分析师看来,他们的工作与(主动)搜索威胁的那些人不同:“分析师的工作纯粹只是查看安全可控性和测量。比如发生的事件是违约的吗? 有什么(安全)问题吗?”

令人困惑的知识图谱(KG)

发现4:安全分析师,尤其是经验不足的分析师,不知道该如何解释知识图谱(KG),因此他们也并不了解它能给他们的工作带来什么价值。

我们的研究团队花了很多时间在安全运营中心(SOC)上,得出的结论是,QRadar Advisor的有限采用和使用并不只取决于一个因素,而是多个因素的结果。不幸的是,QRadar Advisor团队无法解决所有这些因素。 例如,网络拓扑通常是过时的,因此QRadar无法获得整个网络的准确或全面视图。解决该挑战的方法被认为超出了该项目的范围。 但是,研究小组确实相信,有一个问题可以解决并取得巨大的成功。 首席调研人员觉得,安全分析师之所以没有看到图谱的价值,主要是因为图谱令人困惑,并且没能为安全分析师在需要确定可能违规的性质和程度时提供他们最需要的信息。

另一方面,安全分析师之所以不通过QRadar Advisor去启动安全调查,可以看作这是基于他们对QRadar Advisor的工作方式及其所能提供信息的理解作出的。

“我的理解是,QRadar Advisor是导入QRadar信息的助手,便于你不必遍历所有的QRadar信息…因此,如果你在此处(在QRadar Advisor的洞察分析段落中)获得此消息, 告知我们什么(异常)都没有,那么你就不用单击启动“调查”了。这些都是后台的工作。” –安全分析师

另一方面,研究还表明,由于知识图谱(KG)的复杂性以及他们对于如何使用和解释信息方面的困难,安全分析人员会犹豫要不要使用QRadar Advisor。

研究小组发现,安全分析师希望找到一种解决方案,将通常查找的所有异构信息汇总在一起,并以一种快速回答下列问题的方式呈现出来:

- 相关的连接在网络内部(通过计算机,设备,应用程序等)和安全威胁、攻击者相关的IP或URL之间是存在的,还是已经被阻断了?

- 如果建立了连接,是本地对本地的连接,还是本地对外部的连接?

- 如果建立了本地与外部的连接,那么这个(些)连接涉及哪些本地资产,并且它们是关键资产(比如公司首席财务官的计算机)吗?

- 如果建立了本地-外部连接,用户实际上是否在执行恶意软件?

- 针对网络使用了哪种类型的攻击(例如,恶意软件;网络钓鱼,拒绝服务)?

- 这些攻击在不断发展还是已被遏制?

这一系列问题决定了分析师的工作流程。正如一位分析师描述他/她在使用QRadar调查安全事件时寻找信息所看到的那样:

“这是在远程主机(和可观察到的恶意主机)与本地主机之间建立了的连接,还是被阻断了?如果被阻断,系统是否仍在尝试与其连接(例如,它是一个僵尸网络CnC)?本地资产是否受到感染? 与可观察到的恶意软件有关的本地资产是什么?用户是谁?有效载荷在本地执行吗?如果执行了,则按优先级顺序破坏了哪些资产?过去7天发生了什么? 新事件被添加到犯罪中?” –安全分析师

在问这些问题时,安全分析人员试图快速理解以下内容:

- 是否发生违规;

- 违规的来源;

- 受影响的资产及其重要性;

- 他们正在处理的攻击类型;

- 攻击的范围。

这些变量汇总到一起,使分析师可以“综合分析以确定发生或引起问题的原因”。 团队遇到的安全分析人员很少可以使用QRadar Advisor的当前知识图谱(KG)来回答上面列出的问题。 因此,他们无法迅速对安全事件作出判断。

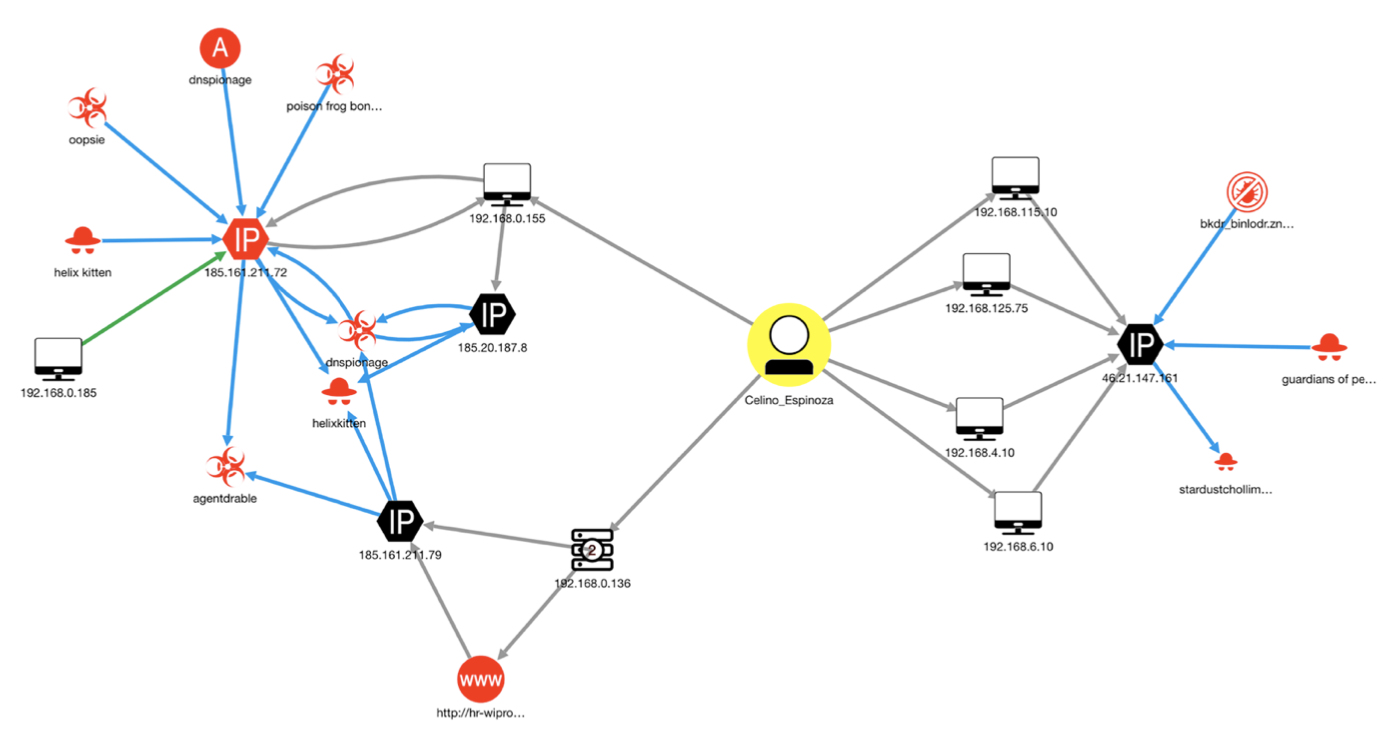

在此,我们需要对产品团队如何使安全分析人员使用知识图谱(KG)进行一些解释。 仅出于说明目的,图5描述了QRadar Advisor对简单安全事件的调查。

图5:QRadar Advisor调查生成初始图。 资料来源:SANS组织 2019年

图5描绘了一个安全事件,可以将其概括如下:与用户Celino Espinoza中间的黄色圆圈)相关联的六个不同的本地资产(黑色的计算机图标)(已到达三个不同的IP地址(黑色的六边形)。在一种情况下,似乎用户访问了位于这些IP地址之一上的可疑URL。图中的所有IP地址都显示出与整套可疑实体(所有红色图标)(例如恶意软件,威胁活动,威胁参与者和病毒)的连接(以及可能的危害)的证据。单击任何这些图标将拉出有关该节点的其他信息,分析人员可以使用这些信息来了解威胁的严重性。单击连接它们(边缘)的任何一条线,将显示有关两个实体之间关系性质的信息。将鼠标悬停在IP地址上将显示IP地址注册和物理位置的地理位置地图。

尽管该图提供了许多有用的信息,但安全分析师并不确定这对他们快速确定警报是否是误报真的有帮助,以及下一步应该采取什么措施。 分析师特别提及了以下几个知识图谱(KG)的局限性:

- 该图未明确定义违规犯罪或攻击来源的实体:即攻击进入网络的位置。

- 该图未能清楚地区分哪些实体在网络内部,哪些实体在网络外部。

- 不清楚哪些(攻击)被阻止了,哪些不是;不清楚下载和执行的是什么(而不是简单下载的)。这些使得安全分析师难以识别即时的威胁,并将其排在潜在威胁的优先级之上。

- 该图没有明确指出哪些潜在受感染的计算机是最有价值、最脆弱或最重要的。

由于这些局限性,无论营销材料如何,分析师通常都不清楚QRadar Advisor的主要价值在哪里。 那些知识图谱(KG)是否可以帮助他们找到“采取行动的根本原因”,从而为他们节省宝贵的调查时间? 还是QRadar Advisor正在为他们进行源犯罪的整个调查? QRadar Advisor是否能帮助他们确定犯罪行为之外的需要折衷的指标,尤其是在他们没有在图谱上看到从而错失的情况下?

人工智能和QRadar Advisor的冲突涵义

发现5:安全主管和安全分析师对QRadar Advisor的知识图谱(KG)的理解和目标并不一致,从而导致他们对QRadar Advisor的应用价值也有不同的感受。

当展示知识图谱(KG)的时候(例如在会议上或与销售有关的演讲中),安全负责人总是对它做出积极的回应,称其为“酷”、“复杂”、和“令人印象深刻”。 他们可以想象自己将其投影到SOC的墙上,或在报表中使用它进行管理。 确实,IBM的一位安全主管向团队承认,潜在客户经常发现该图谱是QRadar Advisor应用中最令人兴奋的一面。 另一位经常向潜在客户介绍该应用程序的内部顾问也称知识图谱(KG)的可视化对安全主管而言“吸引眼球”。 研究小组与安全负责人的对话也显示了他们对图谱的赞赏:

“它很复杂,可以打动人。你可以将它放到屏幕上并展示给高级主管,他们会’哇!’…看起来像互联网。它看起来复杂而令人印象深刻。” –安全主管

这个洞察对研究团队而言是一个意外的发现(基于所授予的地位和声望,使得高级管理层比安全分析师更喜欢知识图谱(KG)可视化)。 与此相反,几乎没有顾问经验的安全分析师将现有的知识图谱(KG)形容为“庞大的蜘蛛网”、“它以不清楚的格式显示了太多的数据”。 对于他们来说,知识图谱(KG)是一个难以理解、难以验证、吓人的人工产物。

研究建议

尽管知识图谱(KG)具有不同的含义,QRadar Advisor团队仍然相信对安全事件进行图形可视化的价值(尽管有些信息难以捉摸)。 提供这样的可视化类似于为安全行业寻找圣杯。

“如果你可以得到这样一个图形可视化的形式,去告诉你需要寻找的内容,或者至少可以为你明确正确的方向,那么它就值百万美元-相比之下,要遍历一万行,然后尝试依靠自己去找到问题,并且在过滤器在继续层层过滤,试图找出是什么原因或发生了什么。试图弄清楚数据……尽可能地往细的方向深挖,但又要确保没有迷失大的方向。” —安全分析师

我们的民族志研究建议确实涵盖了知识图谱(KG),同时也包括了其他在本案例中未讨论的改进方案。 关于如何改进知识图谱(KG)的建议如下:

- 探索新的方式以更好地组织QRadar Advisor收集的信息。比如说,是否有其他打比喻的方式可以指导图谱的可视化?我们如何更好地匹配图谱和分析师的心理模型?

- 在知识图谱(KG)中清楚地区分“发生了什么”、“没有发生什么”,和“可能发生了什么”,即,区分实际的攻击路径和任何“假设”场景。

- 帮助分析人员快速、大概地了解所处理的内容,从而方便他们开始调查。

- 支持用户可以简易地从图谱中挖掘更多信息。

- 允许用户进一步调查与恶意观察有关的违规犯罪行为及已知的攻击策略和技术。

- 确定哪些潜在受损的计算机是最有价值、最脆弱,同时又是最关键的。

- 利用用户的策略来区分合法流量和非法流量并确定事件类型。向他们显示建立了哪些连接、阻止了哪些连接。如果连接被阻止,本地主机是否仍在尝试拨出远程IP。

最终成果

这些建议以及按现状绘制的工作流程图为为期3天的研讨会奠定了基础。在该研讨会中,团队为QRadar Advisor的下一个主要版本确定了三个核心体验目标。其中之一是:“(L1)安全分析师可以查看网络中发生的实际事件,并在此基础上明确潜在隐患,从而更有效地完成优先级的分类。” 这一体验目标最终成为了QRadar Advisor团队设计新的知识图谱(KG)的长期目标。

完成拼图游戏

负责创建新的知识图谱(KG)可视化的两位设计师最首先认识到的是他们真心希望他们的设计能够帮助安全分析师理清头绪,帮助他们解释发生了什么。认识到以前的知识图谱(KG)可视化虽然在技术上是正确的,但却不是容易理解的,并且也不能满足团队为AI设计定下的目标:

“在创建产品时,我们就像是在一个杂乱无章的房间里的孩子。因为是我们创建的产品,所以有些对用户来说看起来混乱或不合时宜的东西,在我们眼中似乎并没有那么疯狂。我们在这个(创造产品的)房间里,和我们的产品一起。但是,在设计数据可视化的时候,我们(仍)需要保障设计是容易理解的、是建设性和结构化的,并保持人工智能的可解释性和透明度。” – QRadar Advisor设计师

设计师常使用打比方的方法用人们(用户)理解和熟悉的东西来解释新的和陌生的概念。 如果QRadar Advisor知识图谱(KG)的当前可视化让我想到了英特网的复杂性和AI的“黑盒”性质,那么对于新的可视化而言,合适的比方又应该是什么呢?

经过大量实验后,QRadar Advisor设计人员发现了一个比喻,它更接近于安全专业人员自己如何解释他们的流程及流程含义——’拼图‘。 ‘拼图’常由许多块组成,其中一些可以组合在一起,有些则不能,甚至还有一些可能会丢失。 设计师解释说,QRadar Advisor应用的工作是向安全分析师提供所有可利用的拼图(例如,引发攻击、用户和资产信息、威胁情报、恶意观察规则),并让分析师“填补空白。”

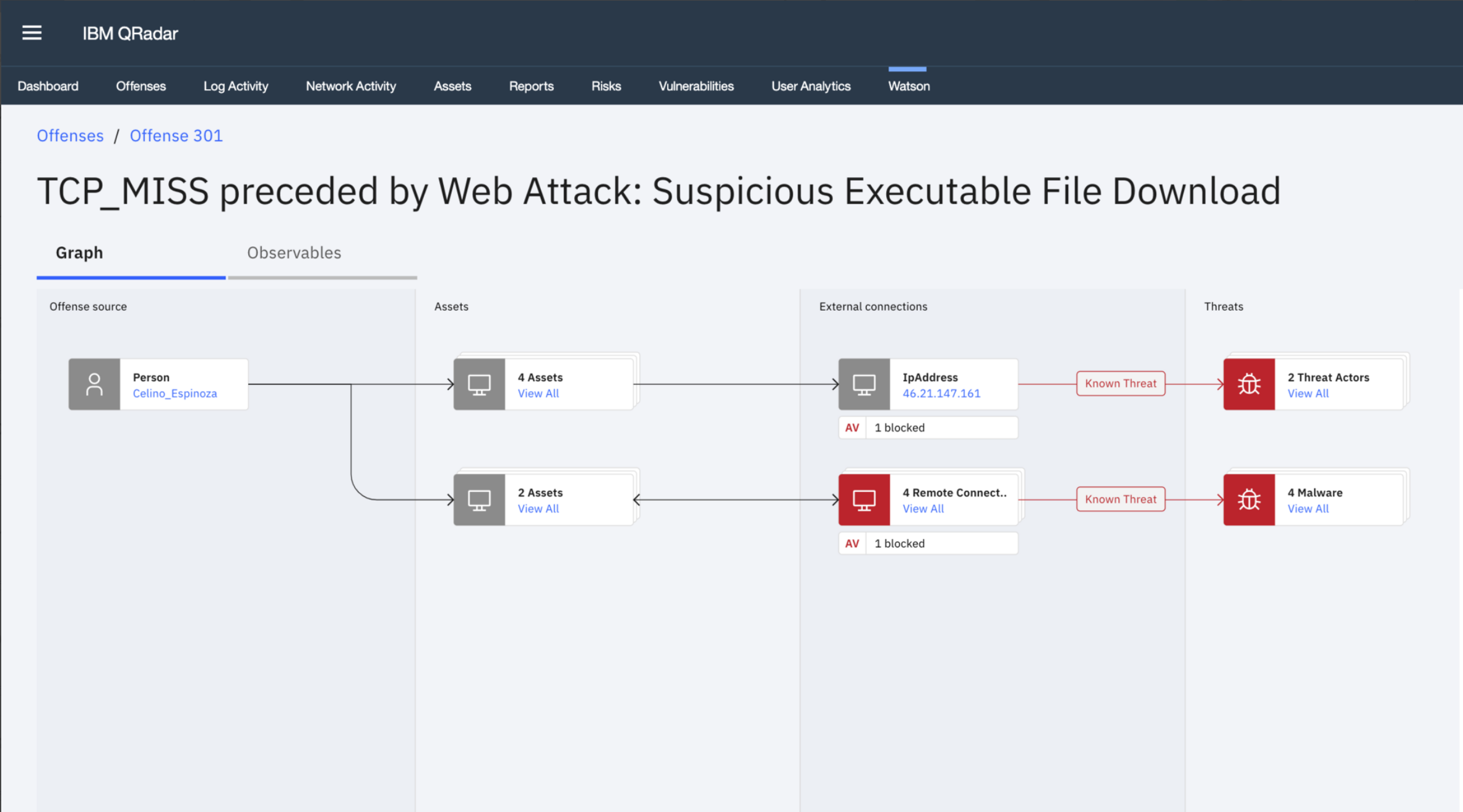

基于这个比方,QRadar Advisor设计师提出了几个不同的设计概念,其中一个重点突出了四个“泳道”。参见图6。知识图谱(KG)数据的这种可视化解决了这么多使用知识图谱(KG)的安全分析人员发现它们很难解释的主要原因,即没有通过节点和边缘的结构化流程。 使用安全事件知识图谱(KG)的传统视觉表示,由于存在许多相互关联的分支,因此实际上没有简单的方法可以遵循从事件源到可能威胁的路径。

与现有的视觉方案相比,新方案将相关实体聚集在一起,降低了复杂性。 可以聚在一起的相关实体不仅取决于实体的类型,还取决于影响它们的威胁。 新的图谱视觉方案还描绘了一条容易理解的路径:从安全事件的源头开始(通常是用户、内部资产、或外部实体),到事件所导致的威胁,使得安全分析人员可以快速识别安全威胁在网络中的进展程度。最后,它减少了旧图谱中的杂乱信息,使得安全分析人员得以有选择性地查看他们所需要的更多详细信息。

图6:新的知识图谱(KG)视觉方案。 资料来源:IBM QRadar Advisor和Watson产品团队。

实际上,新的视觉方案通过模仿安全分析师的工作流程并与他们的思维模型保持一致,迅速为分析师指明了他们关心的问题的答案。图谱清楚揭示了攻击和攻击的根源,以及分析人员应在何处开始调查。 图谱还明确指出了安全事件中涉及的内部资产。 该图还标识了与任何可疑或恶意URL或IP地址建立的任何外部连接,并清楚地指出了网络安全设备是否阻止了威胁。用户可从图谱中获得有效的载荷信息,以及有关实体及其相互关系的其他信息。 最后,图谱还清楚地传达了威胁的类型及其在损害网络方面是否成功或失败。

借助这个新的视觉方案,QRadar Advisor团队为安全分析人员提供了他们所需要的所有‘拼图’,便于他们快速评估他们所发现的违规犯罪是否是假阳还是真实的安全威胁。

研究影响

在民族志研究和研讨会之后,顾问团队与安全领导者和分析人员紧密合作,重新设计了知识图谱(KG)的视觉方案。这个设计是基于之前得到共识的长远目标:“安全分析师可以查看网络中发生的实际事件,并在此基础上明确潜在隐患,从而更有效地完成优先级的分类。” 有趣的是,安全分析师和安全领导都从类似的角度对新的视觉方案表示了赞赏。

“新的设计概念可以让我们更容易地确定这是误报,还是需要进一步研究或上报。它可以让我们更容易地了解过去真正发生了什么。” —安全分析师

“它展示了[数据]结构、涉及的信息,并且清晰定义了连接和资产类型。” —安全分析师

“老实说,我非常感谢此图中组织信息的方式。 这个看起来干净了很多。 当调查中包含数百个IP和多个网络安全违规情况时,想从中轻易地得出重要的信息几乎是不可能的。 它们真的非常杂乱无章。” —安全领导

确实,一些安全领导者询问QRadar Advisor团队是否可以支持两个知识图谱(KG)。 但是,当被告知“否”时,安全领导者选择了新设计的知识图谱(KG),这无疑是出于他们自己也有部分的分析师背景的考虑。

IBM将在2020年第一季度发布带有Watson的新版本QRadar Advisor和新的KG可视化知识图谱(KG)。 时间会证明新的图谱是否会增加使用量和销售量。但是团队(包括高层管理人员)仍然对他们做出的选择充满信心。 这种确定性在很大程度上归因于我们对知识图谱(KG)可视化的研究促使他们做出了决定,同时我们的研究也验证了用户对新图谱的偏好。

设计团队在QRadar Advisor的工作也影响了团队在IBM进行AI设计的方式。 设计团队会定期与企业的团队协商如何达到以用户为中心的目标,从而推动开发新的AI体验。此外,该知识图谱(KG)已被用作IBM开源设计系统的一个组成部分,目前正通过IBM进行专利申请。

结论

通常,人们对AI感到矛盾。 根据一种主流的观点,人们在未来很可能会体验到人工智能带来的更高生产力和效率。 另外一种观点则持有相反的看法–人类将变得越来越缺乏自主性,无法控制自己的生活,无法做出独立于AI工具和技术的决策和行动。 Watson的QRadar Advisor的客户和用户也是如此。 他们相信AI的力量可以向他们提供他们所不知道的知识和应该做什么的建议,但是同时他们也对使用一个工具或任何工具来替代人是否可行以及是否符合他们(用户自己的)兴趣有所质疑。

和用户一样,人工智能企业解决方案产品团队也存在冲突。 他们相信AI产品的强大功能旨在让用户的生活受益,但他们也认识到,他们正在开发的产品会减少对人的需求(或被人们误认为是“低级”的任务和技能)。

人类是-并且永远是-不可或缺的重要一环。人类不仅是消费者,而且一直是AI模型预测洞见的产生者。 人才是人与AI、人与AI预测洞见之间相互交互的界面和视觉的创造者。

通过探索QRadar Advisor团队如何决定将一个知识图谱(KG)的视觉设计替换为另一个知识图谱(KG)的设计的过程中,本案例揭示了人和技术之间是难以分割的。 另外,本文也发现人工智能及其自动化对人和机构的威胁要比某些暗示来得少。有没有可能人工智能其实更像是一种中立的力量,其确切的影响力以及它所受到的影响正是由人与它的互动所塑造出来的?

可以肯定的是,随着新技术的引入、采用和适应,变化将会发生。 但是,这些变化的本质却未必会有所不同。 通过挑战如何将人工智能的洞察向分析师展示,并提出一种更加符合分析师心理模型的(视觉)展示方案,QRadar Advisor团队颠覆了‘人类在人工智能的未来或人工智能的表达中丝毫不起作用’的观念。 这其中离开不了人(包括设计师、工程师、产品经理、安全分析师和安全领导者,他们致力于搭建对用户可以使用以及有价值的产品)——需要人去找到一种容易理解的方式去展示(智能)信息,并在此过程中,揭示AI和人共存的自然特性以及AI需要‘人’这个因素的参与。 通过这样做,他们使得人们有信心去挑战‘AI是未来预知者‘这一说法(这种说法认为人在提高生产力的同时,需要降低独立自主性)。

承认人类和非人类(如人工智能)是共生的伙伴关系也对“人机交互”的概念提出了挑战。 从共生合作的角度出发进行设计,意味着产品团队必须考虑人类和非人类参与者之间的相互依赖性以及对两个实体都开展设计。正如Farooq和Grudin(2016:32)所说:“良好伙伴关系的本质是理解对方为何如此行事。 要了解人和人工智能之间的复杂行为,就需要通过长期调研或者民族志的方法,以便最终得以重现真实的场景和人物画像。”

引用: 2019 EPIC 会议文集, pp 341–361, ISSN 1559-8918, https://www.epicpeople.org/epic

作者介绍

Liz Rogers是IBM Security的设计研究实践负责人。在获得威斯康星大学麦迪逊分校的文化人类学博士学位之后,她进入了产品创新领域继续发展。 她在设计行业拥有超过18年的经验。在深入了解用户需求、动机和行为的基础上,帮助团队设计了优秀的产品经验。

翻译简介:

Xiaochen Liu, 正在学习数据分析的用户体验研究员,现在是北德州大学的硕士研究生和助教。曾经任职于咨询公司,协调团队洞察用户需求,完善服务产品设计。

校对简介:

Shuning Wang, 一个对各种人和事物好奇的用户体验设计者。现任职于HCL Software。希望通过调研和改进,带给用户轻便的产品使用体验。

备注

致谢:我要感谢本文的策展人帕蒂·桑德兰(Patti Sunderland)提供的支持、鼓励和参与。没有她,这篇论文就不会存在。 我还要感谢顾问团队中的两位设计师Terra Banal和Andi Lozano。 两位都是很棒的设计师和朋友。 没有他们,就不会有新的可视化知识图谱(KG),我们的用户研究也不会像过去那样成功。最后,我要感谢整个QRadar Advisor团队,以及帮助我们设计新知识图谱(KG)的安全分析师和领导。 我很期待后续的影响。

1. 在较小的公司组织中,一个人担当多个角色,身兼安全领导、安全分析师、事件响应者和威胁情报分析师的情况并不少见。更大、更成熟的安全团队从不同程度区分这些角色。我们可以采用很多不同的方式来区分这些角色。比如,使用Indeed.com之类的网站进行简单的搜索就可以看到有很多不同的方式可以来判别那些“安全领导”以及他们所承担的相关责任和任务。例如,创建、实施、和监督政策、程序和具体项目,以确保降低风险、遵守法规、并保护公司的资产不受内外网络安全威胁的影响。具体职位头衔包括首席安全官、安全和风险经理副总裁、IT风险管理总监等。同样,SOC分析师、信息安全分析师和安全工程师等,则需要做的首要工作包括保护公司资产不受攻击和攻击者工具的侵害,检测网络安全事件的发生以及调查攻击者的活动和存在情况等。为了语义清晰和简单起见,本文对于具有相似职责、工作目标、痛点和用户需求的员工个体都给予了统一的称谓 – 详见“安全分析师”和“安全领导”。

参考文献

Boyd, Dana and Kate Crawford, 2012, Critical Questions for Big Data, Information, Communication and Society. DOI: 10.1080/1369118X.2012.678878

Capgemini Research Institute, 2019, AI in Cybersecurity Executive Survey. https://www.capgemini.com/wp-content/uploads/2019/07/AI-in-Cybersecurity_Report_20190711_V06.pdf

Cylance, 2018, How Artificial Intelligence Is Liberating Security. https://www.blackhat.com/sponsor-posts/06252018.html. Accessed August 27, 2019.

Future of Humanity Institute, University of Oxford, Centre for the Study of Existential Risk, University of Cambridge, Center for a New American Security Electronic Frontier Foundation, and OpenAI, 2018, The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation.

Klinger, Ulrike and Jakob Svensson, 2018, The End of Media Logics? On Algorithms and Agency. New Media & Society 2018 (12).

Leonardi, Paul, 2011, When Flexible Routines Meet Flexible Technologies: Affordance, Constraint, and the Imbrication of Human and Material Agencies. MIS Quarterly 35 (1): 147-167.

Moss, Emanuel and Friederike Schuur, 2018, How Modes of Myth-Making Affect the Particulars of DS/ML Adoption in Industry. Ethnographic Praxis in Industry Conference Proceedings 2018: 264-280.

Neff, Gina & Nagy, Peter. 2016, Talking to Bots: Symbiotic Agency and Case of Tay. International Journal of Communication 10: 4915-4931; 2018, Agency in the Digital Age: Using Symbiotic Agency to Explain Human–Technology Interaction. DOI: 10.4324/9781315202082-8.

Orlikowski, Wanda J., 2007, Sociomaterial Practices: Exploring Technology at Work. Organization Studies 28 (09): 1435 – 1448. DOI: 10.1177/0170840607081138

Ortner, Sherry, 1973, On Key Symbols. American Anthropologist. New Series. 75 (5): 1338 – 1346.

Pew Research Center, 2018, Artificial Intelligence and the Future of Humans.

Pfaffenberger, Bryan, 1988, The Social Meaning of the Personal Computer: or, Why the Personal Computer Revolution Was No Revolution. Anthropological Quarterly 61 (1): 39 – 47.

1992, Social Anthropology of Technology. Annual Review of Anthropology 21: 491-516.

Prescott, Andrew, 2019, What the Enlightenment Got Wrong about Computers. https://dingdingding.org/issue-2/what-the-enlightenment-got-wrong-about-computers/

Rose, Jeremy and Matthew Jones, 2005, The Double Dance of Agency: A Socio-Theoretic Account of How Machines and Humans Interact. Systems, Signs & Actions 1 (1): 19-37.

SANS Institute, 2019, Investigating Like Sherlock: A SANS Review of QRadar Advisor with Watson

Seaver, Nick, 2017, Algorithms as Culture: Some Tactics for the Ethnography of Algorithmic Systems. Big Data & Society. July- December 2017: 1-12; 2018, What Should an Anthropology of Algorithms Do? Cultural Anthropology 33(3): 375.